Эволюция z/OS

z/OS представляет собой новейшую операционную систему, спроектированную и разработанную для серверов zSeries с учетом перехода на 64-разрядную архитектуру. Как представитель семейства MVS, z/OS унаследовала основные конструктивные элементы своей предшественницы OS/390, сохранив и развив ее базовые возможности. Поэтому рассмотрение архитектуры z/OS целесообразно начать с исторического обзора, раскрывающего особенности технологии MVS и основные этапы совершенствования ОС вместе с совершенствованием аппаратной платформы (рис. 5.1).

Однако в начале введем несколько важнейших понятий, которые помогут сориентироваться тем читателям, которые только начинают знакомиться с мэйнфреймами IBM.

Пакетное задание (batch job) - внешняя единица работы z/OS. Выглядит как текст, написанный на специальном языке управления заданиями JCL (Job Control Language), в котором указано, какие программы (загрузочные модули), в какой последовательности и с какими данными должны быть исполнены в рамках задания. Задания формируются и направляются в систему пользователями через терминальные устройства, консоли, ранее запущенные программы и т.п.

Адресное пространство (address space) - совокупность ячеек виртуальной памяти, выделяемой под размещение кода и данных принятой к выполнению программы. В z/OS включает также вспомогательные системные таблицы и код. Программа до начала выполнения должна либо размещаться в собственном адресном пространстве, либо получить место в "чужом".

Задача (task) - внутренняя единица работы z/OS. Любая программа может быть представлена программистом как совокупность задач - фрагментов кода, которые могут выполняться параллельно, получая кванты процессорного времени независимо от других задач. Если задание состоит из последовательности вызываемых на выполнение программ, то программа состоит из множества (как минимум - одной) параллельно выполняемых задач. Синонимом задачи в других операционных системах (Windows, UNIX) является термин "поток" (thread).

Набор данных (data set) - термин, означающий именованную совокупность связанных элементов данных, размещаемых во внешней памяти или иных устройствах. Для большинства читателей это не что иное, как файл.

MVS/370 (Multiple Virtual Storage/370)

В соответствии с концепцией MVS, каждая прикладная программа, выполняющаяся на платформе S/370, получает в свое распоряжение виртуальное адресное пространство объемом 16 MB, что существенно увеличивает объем доступной приложению памяти по сравнению с SVS. Это означает также, что может быть увеличено количество одновременно выполняемых приложений. Кроме того, наличие раздельных адресных пространств повышает степень безопасности программ и пользователей, поскольку приложение, работающее в одном адресном пространстве, не имеет возможности (преднамеренно или нет) напрямую обратиться к памяти в других адресных пространствах. Однако в некоторых случаях приложения нуждаются во взаимодействии, когда они обмениваются данными или используют одни и те же общие программы. В MVS/370 для этой цели в каждом виртуальном адресном пространстве была выделена так называемая общая область (common area), в которой резервировалось место для размещения программ (предназначенных в основном для поддержки системных сервисов) и данных, доступных всем приложениям. Остальная часть адресного пространства, защищенная от других приложений, названа приватной областью (private area) (рис. 5.2).

Рис. 5.2. Виртуальные адресные пространства MVS/370

Для того чтобы не расширять объем общей области (и, стало быть, не сокращать объем приватной), для некоторых системных программ MVS выделяются отдельные виртуальные адресные пространства. Для организации взаимодействия с такими программами, а также для взаимодействия между обычными приложениями в архитектуре S/370 был реализован альтернативный механизм межпространственной связи CMF (Cross Memory Facility). Этот механизм основан на специальных процессорных командах, с помощью которых можно передавать данные из одного адресного пространства в другое, а также запускать процедуры из других адресных пространств. При этом используются встроенные средства обеспечения безопасности на основе средств авторизации.

MVS/ESA (Multiple Virtual Storage/Enterprise System Architecture)

Появление архитектуры ESA/370 в 1988 году привело к созданию операционной системы для этой платформы, получившей название MVS/ESA. Основные нововведения в этой версии были связаны с использованием расширенной памяти (expanded storage), впервые реализованной в системе ES/3090 в 1985 году. Расширенная память, являясь фактически продолжением основной (центральной) памяти, стала использоваться для хранения вытесненных из основной памяти страниц, что позволило существенно уменьшить время на страничный обмен по сравнению с применением для этой цели дисковой памяти. Расширенная память адресуется поблочно (размер блока - 4 KB). Объем расширенной памяти мог достигать 8 GB, в то время как основная память была по-прежнему ограничена 2 GB.

В MVS/ESA появились виртуальные адресные пространства нового типа: пространства данных (Data Spaces) и гиперпространства (от HIgh PERformance Spaces - "высокопроизводительные пространства"). Общая схема адресных пространств MVS/ESA представлена на рис. 5.4. Практически в таком виде эта схема сохранилась в последующих версиях MVS и OS/390 и легла в основу построения z/OS.

Рис. 5.4. Виртуальные адресные пространства MVS/ESA

Пространства данных могут иметь размер от 4 KB до 2 GB и адресуются побайтно. Они могут создаваться приложениями для размещения данных произвольного типа и доступа к этим данным в процессе выполнения. В отличие от обычных адресных пространств, в пространствах данных не могут размещаться и исполняться программные коды. Для доступа к данным, размещенным в пространствах данных, в архитектуре ESA/370 в качестве базовых регистров применяются специальные регистры доступа (AR), что позволяет приложениям одновременно взаимодействовать с несколькими пространствами данных (до 16), используя стандартные процессорные команды. Следует отметить, что в MVS/ESA появились пространства данных, создаваемые для нужд операционной системы и используемые специальными системными программами, такими как VLF, LLA, DLF и др.

Гиперпространства представляют собой разновидность пространств данных, но с некоторыми специфическими чертами. Главная особенность заключается в том, что данные из гиперпространств могут вытесняться только в расширенную память (никогда во внешнюю!), что обеспечивает повышение производительности при их обработке. Память гиперпространств адресуется поблочно (размер блока 4 KB).

MVS/ESA SP V4 (Multiple Virtual Storage/Enterprise System Architecture, System Product Version 4)

Очередной вехой в развитии технологии MVS стало появление четвертой версии операционной системы MVS/ESA в 1990 году, ориентированной на архитектуру ESA/390 (ES/9000). Основные изменения системного программного обеспечения были связаны с появлением ESCON-каналов и внедрением элементов технологии сисплекс (Sysplex) для построения многомашинных комплексов. В связи с этим появились новые компоненты и функции, такие как XCF (Cross System Coupling Facility) для управления ресурсами в многомашинной среде, APPC (Advanced Program-to-Program Communications) для организации взаимодействия приложений в распределенной системе на базе протокола APPN. Кроме того, была произведена модернизация стандартных функций MVS для работы в сисплексе.

Механизм управления памятью продолжал совершенствоваться за счет внедрения новых алгоритмов страничного обмена (например, был реализован блочный обмен (block paging)), более надежных методов защиты и распределения рабочей нагрузки. В третьем выпуске MVS/ESA SP V4 был сделан первый шаг в сторону интеграции MVS и UNIX и вступления MVS в сообщество открытых систем: реализована поддержка интерфейса прикладного программирования (API) для C/C++ приложений в соответствии с международным стандартом IEEE POSIX 1003.2 (Portable Operating System Interfaces UNIX).

MVS/ESA SP V5 (Multiple Virtual Storage/Enterprise System Architecture, System Product Version 5)

Пятая версия MVS/ESA была выпущена в 1994 году, она предназначалась для установки на серверы 9672 (Parallel Enterprise Server). Данная версия обеспечивала полную поддержку технологии параллельного сисплекса (Parallel Sysplex). В ней впервые был представлен модуль управления рабочей нагрузкой WLM (WorkLoad Manager), дающий возможность рационального распределения системных ресурсов между приложениями на основе сформулированных целей функционирования.

В релизе 2.2 были существенно расширены возможности UNIX-сервиса, получившего в то время название Open Edition ("открытая редакция"). Это название подчеркивало полную поддержку возможностей стандарта открытых систем X/Open Portability Guide, принятого многими разработчиками UNIX-систем. Данный стандарт унифицирует набор функций интерфейса системных вызовов (API) и интерфейс пользователя (shell) для переноса программного обеспечения и повышения мобильности пользователей открытых систем независимо от платформы. Таким образом, в MVS была интегрирована пользовательская оболочка shell UNIX, реализована поддержка иерархической файловой системы UNIX и стало возможным использование приложений на языке С/С++, написанных для UNIX-компьютеров. Одновременно в рамках UNIX-сервиса были представлены компоненты для поддержки распределенных вычислений на основе стандарта DCE (Distributed Computing Environment).

Для повышения эффективности обработки пакетных заданий при обработке последовательных наборов данных был введен компонент BatchPipes/MVS и применена технология Hiperbatch.

Значительные изменения коснулись коммуникационных сервисов. eNetwork Communication Server объединил средства поддержки вычислительных сетей на базе двух протоколов: SNA и TCP/IP. Для доступа пользователей локальной сети NetWare к ресурсам S/390 добавлен компонент LANRES, а для реализации функций файл-сервера для пользователей, использующих рабочие станции OS/2, DOS, Windows, UNIX-компонент LAN Server for MVS.

MVS/XA (Multiple Virtual Storage/eXtended Architecture)

К концу 70-х предел в 16 MB для приложений становился все более заметным ограничивающим фактором. Переход на архитектуру S/370-XA (eXtended Architecture) обеспечил расширение разрядности адреса до 31 бит, что дало возможность в новой версии операционной системы MVS/XA (1983) создавать виртуальные адресные пространства размером 231 = 2 GB (рис. 5.3). Этот объем виртуальной памяти, выделяемый приложению, применялся вплоть до перехода на 64-разрядную архитектуру zSeries (z/Architecture).

Рис. 5.3. Виртуальные адресные пространства MVS/XA

Для сохранения преемственности структура виртуального адресного пространства MVS/XA в младших 16 MB осталась прежней. Свыше границы 16 MB (как стали говорить "above line" - "над линией") появились расширенная общая область (Extended Common Area), как продолжение общей области MVS/370, и расширенная приватная область (Extended Private Area), дающая дополнительное жизненное пространство для 31-разрядных приложений. Механизм межпространственной связи (CMF) был адаптирован к новому формату адресных пространств.

Следует отметить, что для поддержки "старых" приложений, разработанных для MVS/370, в MVS/XA была сохранена возможность переключения в режим 24-разрядной адресации. В этом случае приложения могли использовать по-прежнему только 16-мегабайтную область адресного пространства.

в 1995 году означало коренное

Появление OS/390 в 1995 году означало коренное изменение принципов построения архитектуры операционной системы по сравнению с предшествующими версиями. MVS/ESA SP рассматривалась как совокупность программных продуктов (компонентов), каждый из которых распространялся, устанавливался и обслуживался отдельно от других. К тому же продукты имели различные циклы обновления версий, что не только вызывало проблемы при сопровождении системы, но и снижало общий уровень надежности ее работы.

В основу OS/390 легла концепция интеграции всех ее компонентов, которые, во-первых, разрабатываются и тестируются как единый программный комплекс и, во-вторых, поставляются покупателям в виде единого пакета. Все множество компонентов системы делится на две категории - базовые и опциональные. Базовые компоненты (base elements) обеспечивают поддержку основных системных функций и являются обязательными в любой конфигурации OS/390. Дополнительные возможности системы представлены в виде опциональных компонентов (optional features), необходимость присутствия которых в той или иной конфигурации определяется заказчиком. Таким образом, при планировании закупки OS/390 существует возможность оплатить только необходимые компоненты в составе пакета (все базовые и некоторые опциональные), потеряв, таким образом, возможность использовать остальные. Однако в дальнейшем при необходимости можно активизировать отключенные опциональные компоненты, оплатив заказ и выполнив предусмотренную IBM стандартную процедуру "динамического включения" (dynamic enablement).

Представленная архитектура и установленная технология поставки существенно облегчают процесс инсталляции и сопровождения операционной системы. Обновления для всех компонентов, а также новые компоненты каждые полгода выпускались IBM в виде нового релиза OS/390. Первые три релиза вышли в первой версии (OS/390 V1 R1-R3), остальные - во второй (OS/390 V2 R4-R10).

Второе направление, по которому шло обновление и модернизация OS/390, - превращение ее в серверную операционную систему корпоративного масштаба, поддерживающую множество серверных функций на основе промышленных стандартов и современных информационных технологий.

Среди реализованных в OS/390 сервисов можно выделить:

системный сервис: базовые функции операционной системы;коммуникационный сервис: сетевое взаимодействие с пользователями и устройствами в гетерогенной вычислительной среде на базе протоколов SNA и TCP/IP;LAN-сервис: функции сервера данных и печати в локальных вычислительных сетях;разработка приложений (application enablement): поддержка объектной технологии и графического интерфейса для конечных пользователей;UNIX-сервис: полная поддержка приложений и пользовательской среды UNIX в рамках стандарта открытых систем XPG4.2;сервис распределенных вычислений: поддержка приложений и управление данными в распределенных вычислительных системах на основе промышленного стандарта DCE;Web-сервис: поддержка http-сервера и сервера приложений Java;сервис безопасности: авторизация пользователей, защита системных ресурсов, сетевая безопасность, криптография.

Подробно сервисы и компоненты OS/390 будут рассмотрены далее в настоящей главе, поскольку большая часть из них полностью или с небольшими изменениями вошла в состав z/OS.

OS/390 может использоваться для установки на все модели S/390 Parallel Enterprise Server G5 и G6, IBM ES/9000 Processor Unit 9021 и 9121, S/390 Multiprise 2000 и Multiprise 3000 Enterprise Server, а также на серверы z900 (только V2R6 и старше), и поддерживает 24-разрядный и 31-разрядный режимы адресации MVS. Отметим, что версия OS/390 V2R10 при установке на серверы z900 поддерживает также 64-разрядный режим адресации и играет особую роль при переходе на операционную систему z/OS, о чем пойдет речь ниже.

Первые шаги

Прежде всего, следует отметить, что эволюция операционной системы z/OS связана в первую очередь с изменениями, которые касаются методов управления основной памятью. В период "младенчества", связанный с платформой S/360, операционные системы использовали технологию распределения памяти между параллельно выполняющимися программами на основе прямого "деления" физической памяти (OS/MFT и OS/MVT).

В начале 70-х годов, с появлением новой модели S/370, произошел переход на технологию виртуальной памяти. Концепция виртуальной памяти обеспечивает более эффективное использование основной памяти ЭВМ благодаря реализации следующих принципов:

разрывное размещение программ в физической памяти блоками - страницами;размещение страниц программы частично в основной, а частично - во внешней памяти;обязательное присутствие страниц программы в основной памяти лишь в период ее активности (когда программа выполняется процессором);динамический обмен страницами между основной и внешней памятью;динамическое преобразование адресов.

Первой ласточкой, возвестившей в 1972 году эпоху виртуальной памяти, стала операционная система Virtual Storage 2 (OS/VS2), более известная сегодня как SVS (Single Virtual Storage). SVS обеспечивала поддержку единого виртуального адресного пространства размером 16 MB (при 24-разрядной адресации) для всех параллельно работающих программ. При этом реальный объем физической памяти мэйнфрейма в то время едва мог достигать 1-2 MB.

В 1974 году SVS уступила место операционной системе MVS (Multiple Virtual Storage), в которой были реализованы архитектурные принципы, на десятилетия определившие направление развития операционных систем и сохранившиеся с некоторыми изменениями в современных системах OS/390 и z/OS. Поэтому имеет смысл более подробно рассмотреть основные этапы развития технологии MVS [1].

Рекомендации по переходу на z/OS

Для организаций, использующих большие серверы IBM, чрезвычайно актуальной является проблема перехода с платформы G5/G6, работающей под управлением OS/390, на серверы zSeries и операционную систему z/OS. IBM рекомендует плавную пошаговую процедуру перехода, в основе которой лежит принцип: при смене платформы сохранять некоторое время старую операционную систему, а замену операционной системы производить на старой платформе [1], [2], [3]. Во всех случаях перед установкой z/OS рекомендуется сначала установить OS/390 V2R10 для более плавной и безболезненной миграции. Дело в том, что IBM выпускает специальный пакет обновления z/OS V1R1 Upgrade Package (PUP) для OS/390 V2R10, позволяющий произвести обновление автоматически.

Рис. 5.5. Порядок перехода на серверы zSeries и операционную систему z/OS

На рис. 5.5 представлены два основных варианта перехода при стартовой позиции А (G5/G6+OS/390 R6-R9). Первый вариант включает шаги A-B-D-G, где сначала производится последовательное обновление операционной системы до z/OS на "старой" платформе G5/G6. Во втором варианте (шаги A-C-E-(F)-G) предлагается сначала обновить сервер, а затем приспосабливать к нему операционную систему, возможно, с включением 64-разрядного режима в OS/390 R10 (F).

Сосуществование версий OS/390 и z/OS

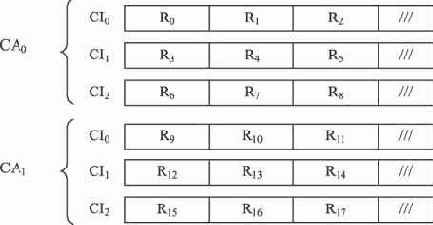

Проблема сосуществования версий заключается в возможности использования различных версий операционной системы в мультисистемных конфигурациях с разделением общих ресурсов, таких как LPAR и Parallel Sysplex. Обычная практика компании IBM заключается в поддержке сосуществования на уровне четырех последовательных релизов. Однако в период перехода к z/OS это правило нарушается для создания более благоприятных условий для такого перехода (таблица 5.2). Так, например, z/OS V1R1 может взаимодействовать со всеми релизами OS/390 второй версии (V2R6-V2R10). Начиная с z/OS V1R5, возобновляется действие ограничения сосуществования в рамках четырех релизов и, таким образом, из списка исключается последний выпуск OS/390.

Таблица 5.2. Допустимые варианты сосуществования версий OS/390 и z/OS

| z/OS | OS/390 | z/OS | ||||||||

| V2R6 | V2R7 | V2R8 | V2R9 | V2R10 | V1R1 | V1R2 | V1R3 | V1R4 | V1R5 | |

| V1R1 | + | + | + | + | + | + | - | - | - | - |

| V1R2 | - | - | + | + | + | + | + | - | - | - |

| V1R3 | - | - | - | + | + | + | + | + | - | - |

| V1R4 | - | - | - | - | + | + | + | + | + | - |

| V1R5 | - | - | - | - | - | - | + | + | + | + |

Z/OS

z/OS - новая операционная система семейства MVS, выпущенная в октябре 2000 года для поддержки 64-разрядной архитектуры (z/Architecture) на платформе zSeries (z900, z990, z800 и др.). Размер адресуемой памяти в z/OS достиг 264=16 EB (экзабайт), что дает возможность выделить приложениям соответствующее виртуальное адресное пространство, а также увеличить объем основной памяти (в z900 можно использовать до 64 GB). Расширенная память в 64-разрядном режиме z/OS не поддерживается, в ней нет необходимости, так как для снижения интенсивности страничного обмена теперь можно просто увеличить объем основной памяти. Для обеспечения преемственности сохранена полная поддержка "старых" 31- и 24-разрядных приложений, в том числе заложена возможность для их взаимодействия с 64-разрядными приложениями. В режиме 31-разрядной адресации z/OS можно использовать на платформах S/390 Parallel Enterprise Server G5/G6 и S/390 Multiprise 3000 Enterprise Server.

Следует отметить, что в первых выпусках z/OS шло постепенное развитие и расширение возможностей 64-разрядной адресации. Это касалось как базовых механизмов и отдельных функциональных компонентов операционной системы, так и языковых компиляторов и средств разработки приложений. Параллельно шла модернизация систем промежуточного слоя (например, СУБД DB2, Websphere Application Server и др.), ориентированных на платформу zSeries.

В первом выпуске z/OS V1R1 (Version 1 Release 1) 64-разрядная адресация была реализована только для обращения к физической памяти, а виртуальное адресное пространство по-прежнему ограничивалось 2 GB. Во втором выпуске z/OS V1R2 у приложений появилась возможность использовать виртуальную память свыше 2 GB для размещения данных (но не программных кодов!). Сказанное относится в том числе и к 31-разрядным приложениям, поскольку изменились (стали 64-разрядными) соответствующие системные функции. Кроме того, в данном релизе появилась возможность разрабатывать 64-разрядные приложения на языке ассемблера (High Level Assembler), а также на языках высокого уровня.

В наиболее полном виде возможности 64-разрядной адресации при использовании виртуальной памяти были реализованы в версии z/OS V1R4, вышедшей в 2003 году.

Что касается архитектуры, то операционная система z/OS сохранила основные принципы организации и большинство компонентов, использованных в OS/390. Изменения коснулись функциональности отдельных модулей системы, но главное, что следует отметить, это появление новых важных компонентов:

менеджера ресурсов Intelligent Resource Director (IRD) для динамического управления ресурсами в режиме LPAR с учетом рабочей нагрузки;msys for Setup - мастера по установке и конфигурированию z/OS и ее компонентов, использующий графический диалоговый интерфейс;менеджера лицензий IBM License Manager (ILM), обеспечивающего удобный интерфейс для управления лицензиями на программные продукты на основе стратегии ценообразования IBM Workload License Charges и упрощающего постепенное наращивание возможностей системы.

С 2002 года в рамках семейства операционных систем z/OS выпускается специальная версия под названием z/OS.e, предназначенная для установки только на серверы серии z800. Сохраняя базовые возможности и преимущества z/OS, z/OS.e ориентирована на поддержку информационных систем электронного бизнеса, построенных исключительно на Internet-протоколах и технологиях Websphere Application Server и DB2 и использующих приложения, написанные только на языках Java и C/C++. Выбор z/OS.e является экономичным решением для многих бизнес-приложений.

В ответ на пожелания пользователей периодичность выпуска новых релизов z/OS и z/OS.e была увеличена по сравнению с OS/390 с 6 до 12 месяцев, что позволило снизить затраты на проведение обновления.

Функциональная структура z/OS

Ориентация на поддержку систем электронного бизнеса на базе технологии "клиент-сервер" определила взгляд на функциональную структуру z/OS как совокупность модулей, каждый из которых обеспечивает реализацию сервисов определенного типа и включает некоторую совокупность базовых и опциональных элементов. В составе z/OS выделено 10 функциональных модулей, показанных на рис. 5.6.

Рис. 5.6. Функциональная структура z/OS

Базовые системные функции и средства представлены тремя модулями:

системные сервисы;сервисы администрирования и управления системой;системные сервисы UNIX.

Элементы этих модулей создают основу для функционирования остальных модулей системы, которые в свою очередь связаны со вспомогательными сервисами и с поддержкой ключевых технологий современных информационных систем, включая коммуникационный сервис, сервис безопасности, Web-сервис и др. Предоставляемая z/OS возможность развертывания вспомогательных сервисов на одной машине и в одной среде обеспечивает снижение расходов на настройку и эксплуатацию программного обеспечения, повышает устойчивость работы и эффективность взаимодействия всех компонентов.

Рассмотрим состав и функции отдельных модулей z/OS, принимая во внимание, что некоторые элементы с таким же успехом можно было бы отнести к другим модулям (т.е. границы модулей условны).

Элементы z/OS

Операционная система z/OS построена в соответствии с концепцией интеграции компонентов, реализованной впервые в OS/390, и включает базовые и опциональные элементы. Данная концепция означает, что все программные компоненты системы разрабатываются и тестируются как единый программный комплекс, а распространение и установка системы производится одним пакетом.

Базовые элементы (base elements) являются необходимой и неотъемлемой частью программного обеспечения z/OS, поскольку служат для поддержки наиболее важных функций и сервисов системы. К ним относятся средства управления аппаратными ресурсами, средства управления данными, пользовательские и программные интерфейсы, поддержка коммуникаций и др. Базовые элементы всегда включаются в установочный пакет z/OS.

Опциональные элементы (optional feature) расширяют возможности базовых элементов и обеспечивают поддержку дополнительных функций операционной системы, таких как, например, средства отладки и библиотеки для языков программирования, некоторые средства администрирования и управления хранением данных, средства защиты, аудита и шифрования и т.п. У заказчика есть возможность выбора необходимой ему совокупности опциональных элементов, которые он оплачивает отдельно. Различают два типа опциональных элементов: интегрированные (в документации определяются как priced) и неинтегрированные (unpriced). Все интегрированные опциональные элементы присутствуют в установочном пакете z/OS, однако доступными для установки и использования будут только элементы, выбранные и оплаченные заказчиком. В дальнейшем всегда существует возможность активизировать не заказанные ранее опциональные элементы на основе процедуры динамического включения (dynamic enablement) без необходимости обновления установочного пакета. Неинтегрированные опциональные элементы не входят в установочный пакет z/OS и требуют отдельного заказа и специальной установки.

Следует отметить, что z/OS включает ряд компонентов, которые в то же время либо существуют и распространяются как самостоятельные программные продукты, либо входят в состав других операционных систем (например, z/VM). Такие элементы называют неэксклюзивными (nonexclusive). К ним относятся ассемблер HLASM и связанные с ним инструментальные средства, графические библиотеки и утилиты GDDM, средства создания и просмотра документов в формате BookManager и некоторые другие. Остальные элементы, доступные только в составе z/OS, называют эксклюзивными (exclusive).

Обновляя версии и выпуская новые релизы системы, разработчики вносят постоянные изменения в состав, функции и статус тех или иных элементов. К счастью, эти изменения не столь радикальны и касаются, как правило, лишь небольшого числа компонентов. Это обеспечивает плавность перехода на новые версии, но не избавляет пользователей от необходимости внимательно изучать новшества и изменения, связанные с таким переходом. Приводимый далее обзор функциональной структуры и элементов z/OS дается в соответствии со спецификацией релиза V1R4 [3]. Полный перечень элементов z/OS V1R4 и z/OS.e V1R4 представлен в приложении 3.

Коммуникационные сервисы

Данная группа сервисов содержит средства интеграции компьютеров zSeries в распределенные многомашинные вычислительные системы на базе современных сетевых протоколов. Базовый элемент z/OS коммуникационный сервер (Communications Server) обеспечивает защищенную поддержку основных коммуникационных решений для корпоративных сетей и включает два сервиса: IP и SNA.

Сервис IP предназначен для реализации взаимодействия на базе широко распространенного сегодня благодаря Internet протокола TCP/IP. В рамках IP-сервиса, помимо базовых средств передачи данных, поддерживаются все важнейшие протоколы прикладного уровня, включая Telnet, FTP, SMTP, RPC и др. На основе TCP/IP функционируют и некоторые другие сервисы z/OS (например, сервис поддержки электронного бизнеса), а также различные системы промежуточного слоя, такие как CICS, IMS, Websphere и др.

Сервис SNA предназначен для поддержки вычислительных сетей, построенных на базе разработанного IBM стандарта SNA (System Network Architecture), известного ранее как виртуальный телекоммуникационный метод доступа VTAM. В рамках данного стандарта реализован протокол APPN (Advanced Peer-to-Peer Networking), обеспечивающий интерфейс между приложениями хоста и ресурсами сети SNA и связывающий пользователей сети. В рамках SNA реализована технология AnyNet (известная также по названием MPTN - multiprotocol transport networking), обеспечивающая прозрачное взаимодействие пользователей и приложений, находящихся в сегментах сети, использующих различные протоколы (IP и SNA). Так, например, приложения SNA без каких-либо изменений могут обмениваться данными и управлять удаленными устройствами через IP-сеть (режим AnyNet SNA over IP). В то же время приложения, использующие функции библиотеки IP сокетов (С socket API), могут взаимодействовать между собой через сеть SNA/APPN (режим Sockets over SNA), а также получать простой и быстрый доступ к ее ресурсам.

Оба коммуникационных сервиса могут использовать встроенные средства шифрования данных на основе 56-разрядного алгоритма DES. Для расширения возможностей шифрования в составе z/OS предусмотрен опциональный неинтегрированный компонент Communications Server Security Level 3, использующий 64-разрядные ключи и алгоритм TDES.

Кроме сервисов IP и SNA, коммуникационный сервер поддерживает функции управления сетевой печатью (Communications Server NPF (Network Print Facility)), а также некоторые функции сетевой защиты на базе технологии Firewall, включая фильтрацию IP-пакетов, трансляцию адресов (NAT), виртуальные сети (VPN).

Вторым базовым элементом коммуникационных сервисов является средство поддержки OSA (OSA Support Facility (OSA/SF)). OSA/SF обеспечивает дружественный интерфейс для контроля состояния адаптеров OSA (OSA Express и OSA-2) - аппаратуры сетевого взаимодействия с устройствами IP и SNA/APPN сетей на базе различных протоколов (Gigabit, Token Ring, Ethernet/Fast Ethernet, ATM, FDDI и др.).

Более подробно коммуникационные сервисы рассмотрены в главе 4.

Сервис электронных публикаций

Для создания и распространения электронных документов IBM использует собственный формат, получивший название BookManager по имени семейства соответствующих программных продуктов. В составе z/OS представлен полный комплект электронной документации в указанном формате, а также три компонента для работы с ней:

BookManager BUILD - опциональный элемент, служащий для создания электронных документов в формате IBM BookManager;BookManager READ - базовый элемент, служащий для просмотра электронных документов, поддерживает функции поиска;BookManager BookServer - базовый элемент, преобразующий документы, созданные в формате BookManager, в формат HTML для последующего отображения через Web-браузер.

Следует отметить, что использование графических иллюстраций в электронных документах основано на возможностях компонента GDDM.

Сервис печати

Для управления печатью и организации сетевого доступа к принтерам z/OS служит опциональный элемент сервер печати Infoprint Server. Сервер печати состоит из следующих компонентов:

Print Interface - принимает запросы вывода на печать от системных сервисов UNIX и от удаленных систем в IP-сети, формирует выходные наборы данных печати в спуле JES2 или JES3 и, наконец, последовательно выводит данные на локальный или удаленный принтер;Windows Client - клиент Windows, используемый для передачи документов и атрибутов заданий серверу печати z/OS;IP Printway - передает наборы данных печати из спула JES2 или JES3 на удаленные принтеры в IP или SNA сети;NetSpool - переадресует потоки вывода на печать, формируемые VTAM-приложениями, и размещает их в спуле JES2 or JES3 для последующей печати.

Сервер печати поддерживает множество различных форматов представления документов, включая PostScript, PCL, ASCII, а при установке дополнительных расширителей - PDF, XML и SAP OTF.

Сервисы администрирования и управления системой

Данная группа сервисов включает набор базовых и опциональных компонентов, предназначенных для установки, конфигурирования, настройки различных элементов и сервисов z/OS, а также для обеспечения оптимальных условий их функционирования.

Базовый компонент конфигуратор оборудования HCD (Hardware Configuration Definition) предназначен для описания начальной конфигурации, а также динамической реконфигурации аппаратного обеспечения и устройств ввода-вывода. Опциональный элемент HCM (Hardware Configuration Manager) представляет собой дополнение к HCD, позволяющее конфигурировать оборудование с помощью графического пользовательского интерфейса.

Программа модификации системы SMP/E (System Modification Program/Extended) является базовым элементом и представляет собой инструментарий, предназначенный для установки и обновления программных продуктов z/OS, а также инвентаризации установленного программного обеспечения системы.

Ранее отмечалось, что в z/OS V1R1 появился новый компонент msys for Setup (Managed System Infrastructure for Setup) - мастер для настройки параметров z/OS и приложений, выполняемых под z/OS на основе графического интерфейса в стиле Web. Вызов мастера может производиться авторизованными пользователями непосредственно с рабочей станции. Диалог настройки рекомендует пользователю наилучшие сочетания параметров, которые он может изменить, либо согласиться с ними. Обновление параметров осуществляется автоматически. Продолжением и развитием технологии msys стало появление в z/OS V1R2 нового базового компонента msys for Operation, предназначенного для автоматизации решения задач сопровождения и администрирования системы в сисплексе.

Подсистема управления данными DFSMS, упоминавшаяся при рассмотрении системных сервисов, представлена в сервисах администрирования четырьмя опциональными компонентами:

DFSMSdss (data set service) - средства администрирования данных и устройств внешней памяти на магнитных дисках (резервное копирование, восстановление, дефрагментация);DFSMShsm (hierarchical storage manager) - средства оптимизации хранения наборов данных на различных носителях в зависимости от интенсивности использования и обеспечения сохранности данных;DFSMSrmm (removable media manager) - средства управления сменными ленточными и оптическими носителями;DFSMStvs (transactional VSAM service) - поддержка параллельной обработки наборов данных VSAM для пакетных заданий и транзакций CICS.

Следующие два компонента из рассматриваемой группы сервисов относятся к разряду опциональных, однако пользователи редко отказываются от них. Компонент SDSF (System Display and Search Facility), используя диалоговые панели ISPF, обеспечивает контроль и предоставляет информацию о текущем состоянии всех заданий в системе, а также поддерживает средства управления системой с помощью консольных команд. Компонент RMF (Resource Measurement Facility) - менеджер сбора данных о ресурсах - предоставляет диалоговый интерфейс и средства для получения отчетов об использовании любых ресурсов z/OS и о параметрах производительности как в текущий момент, так и за указанный период времени.

Следует отметить, что множество компонентов, используемых для администрирования и управления системой, несколько шире, нежели представлено в группе сервисов администрирования. Однако эти средства (например, RACF) отнесены к другим функциональным модулям, что подтверждает тезис об условности данной классификации (сказанное верно для любой классификации вообще).

Сервисы для разработки и поддержки приложений

В состав базового программного обеспечения z/OS входят компиляторы множества высокоуровневых языков программирования (HLL, High Level Languages), включая C, C++, COBOL, Fortran и PL/1, а также два редактора связей для получения загрузочного кода приложений (Linkage Editor и Binder). У разработчиков есть возможность производить компиляцию и редактирование связей как в пакетном, так и в интерактивном режиме, используя интерфейс TSO/ISPF или UNIX shell. В то же время на рынке существуют внешние продукты, позволяющие разрабатывать приложения для z/OS на рабочих станциях с использованием визуального графического интерфейса (например, IBM Visual Age).

Важнейшим базовым элементом, обеспечивающим поддержку универсальной среды выполнения программ, созданных на различных языках программирования, является так называемая языковая среда LE (Language Environment). LE включает единые для всех HLL приложений средства управления запуском и завершением программ, формирования сообщений времени выполнения, распределения памяти, а также обеспечивает универсальный программный интерфейс для взаимодействия "разноязыких" приложений. Кроме того, LE содержит набор общих статических и динамических библиотек, используемых различными HLL-приложениями, а также специфические библиотеки для каждого HLL.

Для разработки быстродействующих и экономичных приложений для платформы zSeries поддерживается высокоуровневый ассемблер HLASM (High Level Assembler), включающий компилятор, макросредства и необходимые библиотеки. Дополнительные инструментальные средства разработки ассемблерных программ, расширяющие возможности HLASM, поставляются вместе с опциональным компонентом HLASM Toolkit. Отметим, что HLASM является неэксклюзивным элементом z/OS, поскольку используется в составе других операционных систем (z/VM, VSE)

Для разработчиков C/C++ приложений z/OS поддерживает специальную среду разработки, включающую компилятор C, компилятор C++, библиотеки классов, набор утилит и средства отладки. Библиотеки классов C++ представлены базовым элементом C++ IBM Open Class Library.

Остальные возможности реализованы с помощью опционального элемента C/C++ with Debug Tool ( с модификацией, не содержащей средств отладки C/C++ without Debug Tool). Все средства разработки C/C++ приложений ориентированы на использование библиотек и сервисов языковой среды Language Environment.

Для создания и использования графических приложений в составе z/OS присутствует базовый элемент, называемый менеджером отображения графических данных GDDM (Graphical Data Display Manager). GDDM представляет собой мощный набор API-функций для создания, отображения и хранения векторных и растровых изображений и шрифтов. GDDM поддерживает вывод на различные графические устройства, включая дисплейные терминалы, принтеры, плоттеры, и содержит соответствующий набор драйверов и служебных утилит. Расширенные возможности по работе с графикой представлены опциональными компонентами GDDM-PGF2 (Presentation Graphics Feature) и GDDM-REXX2.

Более подробно средства разработки приложений будут рассмотрены в п. 5.1.8.

Сервисы поддержки электронного бизнеса

В настоящее время ядро информационных систем в сфере электронного бизнеса строится на основе Web-технологий. z/OS включает в качестве базового элемента масштабируемый высокопроизводительный защищенный HTTP сервер (IBM HTTP Server), обеспечивающий поддержку множества тонких клиентов, использующих стандартные браузеры для доступа к корпоративным данным. Помимо основных функций, IBM HTTP сервер поддерживает протокол SSL, динамический кэш страниц, выполняет функции proxy-сервера, ведет статистику обращений к Web-узлу.

В состав сервисов поддержки электронного бизнеса включен также базовый элемент текстового поиска (Text Search), выполняющий функции поисковой машины для баз данных и Web. Поисковая машина обеспечивает поддержку сложных запросов для различных национальных языков1), использует алгоритмы нечеткого поиска, ранжирует результаты поиска по релевантности. Кроме того, в состав Text Search входит компонент NetQuestion Solution, производящий полнотекстовый поиск документов, хранящихся в операционной системе z/OS.

Сервисы поддержки распределенных вычислений

Сервисы поддержки распределенных вычислений обеспечивают взаимодействие приложений и управление данными в распределенных вычислительных системах на основе промышленного стандарта DCE 1.1 (Distributed Computing Environment). Фактически DCE представляет собой сетевую операционную систему, обслуживающую работу клиент-серверных приложений в гетерогенных средах (включая IP и SNA сети). В составе z/OS в рамках рассматриваемых сервисов представлено три базовых элемента.

Базовые службы DCE (DCE Base Services) предназначены для разработки и поддержки выполнения клиент-серверных приложений и включают:

службу вызова удаленных процедур (RPC, Remote Procedure Call) - взаимные вызовы программ, работающих на различных платформах, в формате вызова локальных процедур;службу каталога (Directory Services) - ведение общего каталога имен всех ресурсов распределенной системы;службу времени (Distributed Time Services) - синхронизация часов на всех узлах распределенной системы;службу безопасности (Security Services) - идентификация и аутентификация пользователей, приложений и узлов распределенной системы.

Служба поддержки распределенных файлов DFS (Distributed File Service) обеспечивает приложениям прозрачный защищенный доступ к файлам, размещенным на различных узлах сети. Фактически DFS объединяет файловые системы различных ОС в единую глобальную файловую систему, доступную для множества пользователей сети. Одним из новшеств z/OS стало появление файловой системы zFS (zSeries File System), которая может быть использована в дополнение к файловой системе HFS UNIX. zFS, используя аналогичную HFS структуру, обеспечивает значительное увеличение производительности и устойчивости к системным сбоям. Кроме того, в рамках DFS реализована поддержка SMB сервера для доступа клиентов ОС Windows к наборам данных z/OS.

Сетевая файловая система NFS (Network File System) выполняет функции файл-сервера для рабочих станций, персональных компьютеров и других авторизованных систем в сети TCP/IP. NFS-сервер дает возможность удаленным пользователям (клиентам) получить доступ к наборам данных z/OS и файлам UNIX-сервиса, которые могут быть смонтированы как часть файловой системы клиента.

Системные сервисы

В состав системных сервисов входит более десятка базовых и опциональных компонентов, обеспечивающих поддержку фундаментальных функций операционной системы и предназначенных в первую очередь для управления ресурсами и организации вычислительного процесса. Наиболее важными среди них являются компоненты BCP, DFSMSdfp, JES2, TSO/E и ISPF, которые, находясь в тесном взаимодействии, определяют основные технологические принципы функционирования z/OS (рис. 5.7).

Рис. 5.7. Взаимодействие базовых элементов системных сервисов z/OS

Центральную роль в системе играет базовая управляющая программа BCP (Base Control Program), являющаяся ядром системных сервисов и z/OS в целом.

Базовая управляющая программа осуществляет:

управление задачами (диспетчеризация и синхронизация);управление виртуальной и физической памятью;управление вводом-выводом;обработку прерываний и поддержку системных вызовов;управление рабочей нагрузкой и производительностью;управление выполнением программ (связывание, восстановление);поддержку диалога с оператором через консоль;протоколирование работы системы.

В литературе при описании функций BCP часто используют понятие "супервизор" (supervisor), которое можно считать синонимом базовой управляющей программы. В составе BCP выделен ряд важнейших компонентов, таких как программа конфигурирования ввода-вывода IOCP (I/O Configuration Program), менеджеры управления виртуальной, физической и вспомогательной памятью VSM, RSM, ASM (Virtual, Real, Auxiliary Storage Managers), менеджер управления рабочей нагрузкой WLM (Workload Manager), модуль управления системой (сбора статистики) SMF (System Management Facilities), модуль синхронизации задач GRS (Global Resource Serialization), программа связывания (Binder) и некоторые другие. Познакомиться с большинством этих компонентов нам предстоит в данной главе.

Необходимо отметить, что в базовую управляющую программу z/OS интегрировано ядро системных сервисов UNIX, выполняющее ключевую роль при поддержке приложений и некоторых системных компонентов, ориентированных на эту операционную среду.

Вторым важнейшим элементом системных сервисов является подсистема управления данными DFSMSdfp (Data Facility Storage Management System - data facility product), реализующая базовые функции управления данными, хранящимися во внешней памяти, и устройствами хранения данных. Фактически этот компонент поддерживает необходимые низкоуровневые средства для создания, размещения на носителях и последующей обработки наборов данных. DFSMSdfp является базовым элементом, но в то же время существует еще ряд опциональных компонентов семейства DFSMS, которые будут рассмотрены в разделе, посвященном сервисам системного администрирования. Подробное описание всех средств управления данными и внешней памятью будет представлено в п. 5.1.4.

Для обработки пакетных заданий (напомним, что задание представляет собой внешнюю единицу работы z/OS) служит подсистема управления заданиями JES2 (Job Entry System 2). Этот базовый компонент принимает и регистрирует задания, поступающие в систему от различных источников; осуществляет анализ и формирует очереди заданий, а затем передает задания на выполнение базовой управляющей программе. После завершения выполнения задания и получения результатов от BCP, JES2 формирует отчет по заданию (листинг), передает его пользователю или выводит на печать. Альтернативой JES2 является опциональный компонент JES3, который, в отличие от JES2, может использоваться для централизованного управления заданиями в многомашинной системе. Более подробно о подсистеме управления заданиями будет рассказано в п. 5.1.5.

Для организации взаимодействия с пользователями в составе системных сервисов присутствуют два базовых компонента: TSO/E и ISPF. Система разделения времени TSO/E (Time Sharing Option/Extensions) обеспечивает поддержку интерактивного терминального пользовательского интерфейса в режиме командной строки. TSO/E располагает своей системой команд, позволяющих запускать программы и задания, манипулировать наборами данных, контролировать вычислительный процесс и управлять системой с удаленного терминала. Полноэкранный диалоговый интерфейс пользователя

ISPF (Interactive System Productivity Facility) представляет собой среду для разработки и реализации диалога с пользователем на основе стандарта CUA как в текстовом, так и в графическом режиме. ISPF включает текстовый редактор, утилиты для работы с наборами данных, средства разработки и удаленного запуска программ и заданий, а также другие полезные средства для удобного и эффективного взаимодействия с системой. Многие системные компоненты (WLM, HCD, RACF, RMF и др.) используют интерфейс ISPF для настройки и конфигурирования. Описание элементов поддержки пользовательского интерфейса z/OS будет представлено в п. 5.1.7

Системные сервисы UNIX

Сегодня невозможно представить себе z/OS без встроенных возможностей операционной системы UNIX. Базовый компонент UNIX System Services включает системное ядро UNIX (UNIX System Services Kernel) и прикладные сервисы (UNIX Application Services). Ядро UNIX интегрировано в базовую управляющую программу z/OS и поддерживает интерфейс прикладного программирования (API) для всех UNIX-приложений в соответствии со стандартом XPG 4.2.

Прикладные сервисы UNIX включают поддержку классического пользовательского интерфейса UNIX - командного интерпретатора shell и набора стандартных утилит, благодаря которым пользователь UNIX может получить доступ к ресурсам мэйнфрейма привычным для него способом. Кроме того, поддерживается интерактивный отладчик UNIX, который могут использовать разработчики приложений на языке C.

Подробное описание системных сервисов UNIX и примеры использования прикладных сервисов будут представлены в п. 5.1.6.

Службы безопасности

Службы безопасности включают широкий набор функций контроля доступа к системным ресурсам, содержат средства настройки, аудита и управления защитой от несанкционированного доступа к данным в распределенных и централизованных средах, а также обеспечивают эффективное шифрование данных "на лету" благодаря наличию криптографического сопроцессора. Службы безопасности состоят из двух групп элементов: сервера защиты и криптографических сервисов.

Сервер защиты (Security Server) является опциональным интегрированным элементом, служащим для конфигурирования и управления доступом к ресурсам z/OS, и состоит из следующих компонентов:

Средства управления доступом к ресурсам RACF (Resource Access Control Facility) являются базовым звеном сервера защиты и обеспечивают централизованное управление доступом к ресурсам системы на основе авторизации пользователей и приложений в многомашинных и мультисистемных средах. С помощью RACF администратор осуществляет регистрацию всех пользователей системы, настраивает индивидуальные и групповые права и проводит аудит по использованию тех или иных ресурсов (устройств, данных, системных и прикладных программ).

Средства сетевой защиты (Firewall Technologies) предназначены для обеспечения защиты от внешних атак в IP-сети (совместно с коммуникационным сервером), включая поддержку FTP proxy, демона SOCKS, встроенных процедур шифрования на основе алгоритма DES, интерфейса администратора для настройки и конфигурирования.

Сервер LDAP обеспечивает защищенный доступ пользователей к сетевым приложениям на основе стандарта LDAP (Lightweight Directory Access Protocol). Этот индустриальный стандарт служит для создания и ведения каталога пользователей масштаба предприятия, используемого для получения общей информации о пользователях и их атрибутах при аутентификации. LDAP-сервер применяет компонент System SSL, входящий в состав криптографических сервисов.

Служба сетевой аутентификации (Network Authentication Service) осуществляет аутентификацию пользователей на основе стандарта Kerberos Version 5, с использованием криптографических ключей.

Включает программный интерфейс API, известный пользователям Internet под названием GSS-API.

Сервер защиты DCE (DCE Security Server) служит для аутентификации пользователей и серверов сети при использовании клиент-серверных приложений в распределенных системах на основе тесной интеграции с RACF.

Служба PKI (Public Key Infrastructure Services) служит для создания инфраструктуры общих ключей и авторизации сертификатов для внешних и внутренних пользователей на основе Web-интерфейса.

Дополнительные криптографические модули OCEP (Open Cryptographic Enhanced Plug-ins) реализуют прикладной интерфейс (API) для управления серверными сертификатами и защиты серверных ключей.

Отметим, что сервер LDAP, служба сетевой аутентификации, служба PKI и OCEP являются частью базового программного обеспечения z/OS и не требуют специального заказа и установки сервера защиты. В качестве опционального элемента, расширяющего возможности шифрования данных на основе 64-разрядных ключей и алгоритма TDES для службы сетевой аутентификации в состав z/OS входит Security Server Network Authentication Security Level 3.

Криптографические сервисы (Cryptographic Services) являются базовым элементом z/OS. С их помощью реализуют различные методы шифрования данных для обеспечения защиты хранящейся в системе и передаваемой по сети информации от несанкционированного использования. Криптографические сервисы в базовой конфигурации не поддерживают ключи размером более 56 бит и включают следующие компоненты: ICSF, OCSF и System SSL.

Опциональный компонент OCSF Security Level 3 расширяет стандартные возможности шифрования данных за счет использования 64-разрядных битных ключей и алгоритмов TDES, DES, RC2/RC4/RC5.

Опциональный компонент System SSL Security Level 3 обеспечивает конфиденциальность обмена данными между клиентом и сервером на основе протокола SSL и шифрования с использованием ключей длиной свыше 64 бит на основе алгоритмов TDES, AES, RC2/RC4.

Средства поддержки криптографических сервисов представлены в главе 4.

Начальная загрузка и инициализация z/OS

Начальная загрузка z/OS производится с помощью универсальной программы начальной загрузки IPL (Initial Program Load), которая находит и считывает в память модули ядра операционной системы и запускает программу инициализации ядра NIP (Nucleus Initialization Program) [5], [6].

Нужно, чтобы к моменту загрузки были подготовлены и размещены на томах прямого доступа необходимые наборы данных, содержащие системный код, конфигурационные параметры, процедуры, а также страничные наборы данных и наборы данных, предназначенные для хранения генерируемой системой информации (статистика, журналы).

Базовый системный код (ядро z/OS) представлен в библиотечном наборе данных SYS1.NUCLEUS, который всегда размещается на так называемом системном резидентном томе (SYSRES), где должна находиться и программа начальной загрузки IPL. SYS1.NUCLEUS может включать несколько различных вариантов загрузки ядра, каждый из которых представлен в разделе IEANUC0n (n=1-9), а также программу инициализации ядра (NIP) и указатель на главный каталог. Главный каталог (Master Catalog) должен содержать информацию о размещении всех наборов данных, используемых в процессе загрузки.

Дальнейшая загрузка осуществляется под управлением программы инициализации ядра NIP, которая работает в режиме диалога с оператором и использует информацию, представленную в библиотечном наборе данных SYS1.PARMLIB. Этот набор данных состоит из множества разделов, каждый из которых содержит описание параметров конфигурации и настройки операционной системы в виде позиционного текста. Например, в разделе IEASYS содержатся значения основных системных параметров z/OS, в разделе BPXPRM - параметры настройки z/OS UNIX, в CONSOL - характеристики консолей и т.п. Набор данных SYS1.PARMLIB можно назвать системным реестром z/OS. Необходимые при загрузке параметры аппаратной конфигурации системы и характеристики устройств ввода-вывода извлекаются из VSAM набора данных IODF (Input/Output Definition File). Этот набор данных используется для создания в COMMON области блоков управления устройствами (UCB), а также таблицы назначения групповых имен устройствам (Eligible Device Table, EDT).

Кроме указанных наборов данных, на этапе загрузки формируются или используются следующие системные наборы данных:

страничные наборы данных для временного хранения данных, вытесненных при страничном обмене и свопинге;SYS1.PROCLIB - системная библиотека каталогизированных процедур (содержит готовые программы на языке управления заданиями);SYS1.LINKLIB - системная библиотека загрузочных модулей, а также другие библиотеки, описанные в разделе LNKLST набора данных SYS1.PARMLIB (содержат нерезидентные системные программы: утилиты, программы обслуживания, редактор связей и др.);SYS1.LPALIB - библиотечный набор данных, содержащий дополнительные модули z/OS, загружаемые в область LPA, включая системные процедуры, SVC-программы, базовые системные программы методов доступа, некоторые TSO-модули и др. Для загрузки в LPA возможно использование других библиотек, описанных в разделе LPALST набора данных SYS1.PARMLIB;SYS1.MANx - VSAM набор данных, служащий для хранения статистической информации, собираемой модулем SMF (x=A-Z,0-9);SYS1.LOGREC - системный журнал ошибок и сбоев оборудования;SYS1.DUMPxx - системный дамп (содержимое виртуальной памяти), формируемый в случае ошибок при выполнении системных программ (хх=00..99).

На заключительном этапе инициализации системы создается первое виртуальное адресное пространство Master Scheduler ("главный планировщик"), которое, в частности, служит для создания новых системных адресных пространств с помощью специальной программы ACS (Address Space Create). Системные адресные пространства создаются с целью разместить системный код не в общей области, а в приватной. Можно выделить четыре группы системных адресных пространств в зависимости от способа их создания и использования (рис. 5.11):

SYSTEM - системные адресные пространства, создаваемые на этапе инициализации автоматически с помощью главного планировщика;START - адресные пространства, создаваемые по команде оператора START, вводимой с системной консоли или формируемой автоматически для запуска процедур JCL;TSO - адресные пространства, создаваемые для каждого сеанса пользователя TSO, открываемого по команде LOGON;Batch Job - адресные пространства, принадлежащие пакетным инициаторам подсистемы управления заданиями JES и используемые для выполнения пакетных заданий.

Рис. 5.11. Адресные пространства z/OS

Список основных системных, а также запускаемых автоматически при инициализации операционной системы адресных пространств представлен в таблице 5.3.

Таблица 5.3. Основные системные адресные пространства z/OSНаименованиеНазначение

| *MASTER* | Главный планировщик Master Scheduler |

| ALLOCAS | Создание адресных пространств и пространств данных |

| APPC, ASCH | Поддержка сетевого протокола APPC |

| CATALOG (CAS) | Функции каталога |

| BPXOINIT | Инициализация системного сервиса UNIX |

| CONSOLE | Поддержка консольных устройств |

| DFM, DFMCAS, GDEDFM | Управление распределенными файлами (Distributed File Manager) |

| DLF | Средства использования гиперпространств |

| DUMPSRV | Средства формирования дампов |

| HSM, ABARS, ABARxxxx | Менеджер иерархической памяти DFSMShsm, средства резервного копирования и восстановления |

| FTPSERVE | FTP-сервер |

| GRS | Средства глобальной синхронизации ресурсов |

| IOSAS | Супервизор ввода-вывода, поддержка ESCON |

| IXGLOGR | Системный регистратор |

| JES2, JES2AUX, JES2MON | Подсистема управления заданиями JES2 |

| LLA | Средства кэширования оглавлений библиотек в виртуальной памяти |

| NFS | Сетевая файловая система NFS |

| OAM | Сервер данных для ленточных библиотек IBM 3494 и IBM 3495 |

| OMVS | Системный сервис UNIX |

| PCAUTH | Поддержка межпространственной связи |

| RASP | Менеджер реальной памяти RSM |

| RMM | Менеджер управления сменными носителями DFSMSrmm |

| RRS | Служба восстановления ресурсов |

| SMF | Средства управления системой SMF (статистика и измерение производительности) |

| SMS | Подсистема управления внешней памятью |

| SMXC, SYSBMAS | Дополнительные средства управления PDSE наборами данных |

| TCPIP | Средства поддержки TCP/IP |

| TRACE | Трассировка системы |

| VLF | Средства кэширования наборов данных в виртуальной памяти |

| XCFAS | Средства Parallel Sysplex |

| VTAM | Средства поддержки сети SNA/VTAM |

| WLM | Менеджер управления рабочей нагрузкой |

Важнейшим из них является так называемая таблица векторов связей CVT (Communications Vector Table), которая хранится в области ядра и содержит указатели на основные управляющие блоки и системные таблицы, используемые базовой управляющей программой BCP. Местоположение CVT определяется по указателю, записанному в области PSA. Одним из векторов в таблице CVT является указатель на таблицу векторов адресных пространств ASVT (Address Space Vector Table), которая хранится в подпуле 245 и содержит список указателей на управляющие блоки ASCB всех доступных адресных пространств. Как уже отмечалось ранее, блок управления адресным пространством ASCB содержит информацию и указатели, необходимые для управления адресным пространством.

После того как произведен начальный запуск операционной системы z/OS, поддерживается три варианта перезагрузки:

холодная перезагрузка (cold start) - выполняется как начальная загрузка с полной перестройкой содержимого областей виртуальной памяти;быстрая перезагрузка (quick start) - не перестраивается содержимое PLPA; временные наборы данных, размещенные в виртуальной памяти (так называемые VIO), не сохраняются;теплая перезагрузка (warm start) - содержимое PLPA не перестраивается, наборы данных VIO сохраняются.

Реализация базовых функций z/OS

Общая область представлена совокупностью областей, каждая из которых предназначена для определенных целей:

область ядра - Nucleus;область системных очередей - SQA (System Queue Area);область загрузки модулей - LPA (Link Pack Area);область общих сервисов - CSA (Common Service Area);область префиксации - PSA (Prefix Save Area).

В расширенной общей области выделяется дополнительная виртуальная память для перечисленных областей с расположением относительно границы 16 MB в зеркальном порядке.

Область ядра Nucleus/Extended Nucleus содержит базовый системный код и дополнительные элементы ядра z/OS, формируемые в процессе начальной загрузки системы (IPL) на основе набора данных SYS1.NUCLEUS. Состав ядра определяется системным программистом путем настройки раздела NUCLST системного реестра SYS1.PARMLIB. Виртульные страницы области ядра являются неперемещаемыми, то есть всегда загружены в основную память и в страничном обмене не участвуют.

Область системных очередей SQA/ESQA служит для размещения общесистемных таблиц, блоков управления и очередей, состав и содержание которых определяется конфигурацией системы и общим количеством создаваемых в процессе работы адресных пространств. Настройка размера области SQA (ESQA) осуществляется с помощью параметра SQA в разделе IEASYS реестра SYS1.PARMLIB или с консоли оператора. При нехватке памяти для SQA система пытается "занять" необходимое пространство в области CSA. Страницы SQA (ESQA) также являются неперемещаемыми и всегда остаются в основной памяти.

Область загрузки модулей LPA/ELPA предназначена для размещения дополнительных реентерабельных загрузочных модулей ядра, включая SVC-программы и методы доступа, а также некоторые пользовательские приложения. Все указанные программы могут одновременно вызываться множеством задач, работающих в различных адресных пространствах. Модули, загружаемые в LPA/ELPA, должны быть предварительно записаны в библиотечный набор данных SYS1.LPALIB или другие наборы данных, определяемые в разделе LPALST реестра SYS1.PARMLIB.

Таким образом, размер области LPA/ ELPA зависит от количества размещаемых модулей. Учитывая особую роль модулей LPA, система требует их авторизации на основе технологии APF (Authorized Program Facility). Авторизованные модули получают право обращаться к защищенным областям системной и приватной памяти.

Область LPA/ELPA в свою очередь делится на три подобласти:

Pageable LPA (PLPA/EPLPA) - содержит перемещаемые модули;Fixed LPA (FLPA/EFLPA) - содержит неперемещаемые модули;Modified LPA (MLPA/EMLPA) - может использоваться на этапе начальной загрузки системы для временного хранения модифицируемых или обновляемых модулей PLPA.

Область общих сервисов CSA/ECSA служит для размещения общих данных, используемых несколькими активными адресными пространствами, и в том числе для организации обмена (межпространственной связи) между адресными пространствами. Размер области CSA/ECSA устанавливается с помощью параметра CSA в разделе IEASYS реестра SYS1.PARMLIB или с консоли оператора. По умолчанию страницы CSA являются перемещаемыми.

Область префиксации PSA служит для хранения содержимого регистра PSW (старого и нового) при реализации механизма обработки прерываний, а также содержит указатели на важные системные управляющие блоки и таблицы. Данная область поддерживается аппаратно, всегда привязана к началу виртуального адресного пространства и имеет размер 4 KB в системах с архитектурой S/370, 370/XA, ESA/390 и 8 KB в системах с z/Architecture.

Для знакомства со структурой приватной области сначала рассмотрим, как она выглядит в OS/390, то есть в режиме 31-разрядной адресации (рис. 5.9). Мы уже отмечали, что часть виртуальной памяти в пределах первых 2 GB сохранила свою структуру в z/OS. В приватной области выделяются следующие элементы:

регион пользователя - User Region и Extended User Region;область локальных системных очередей - LSQA (Local System Queue Area) и ELSQA (Extended Local System Queue Area);область планировщика работ - SWA (Scheduler Work Area) и ESWA (Extended Scheduler Work Area);подпулы (Subpools) 229, 230 и 249;системный регион - System Region.

Рис. 5.9. Структура 31-разрядного виртуального адресного пространства

Регион пользователя предназначен для размещения пользовательских приложений и данных. После загрузки программ в регион пользователя система исключает из использования оставшиеся незанятыми страницы до поступления запроса на выделение дополнительных страниц в данном регионе. У пользователя есть возможность управлять размером региона с помощью одноименного параметра REGION операторов языка управления заданиями JOB и EXEC (см. п. 5.1.5).

Область локальных системных очередей LSQA/ELSQA содержит таблицы и очереди, ассоциируемые с текущим адресным пространством и выполняемыми в нем приложениями. В частности, здесь хранятся таблицы страниц, сегментов и регионов, формируемые менеджером физической памяти RSM. Отметим, что указанные таблицы участвуют в страничном обмене наряду с прочими перемещаемыми страницами.

Область планировщика работ SWA/ESWA служит для размещения блоков управления задачами (TCB) и других блоков управления, создаваемых для обслуживания приложений адресного пространства. Назначение блоков управления будет рассмотрено позднее.

Подпулы (Subpools) 229, 230 и 249 предоставляют локальную память, доступ к которой реализуется на основе запрашиваемых ключей защиты. Эта область служит для размещения управляющих блоков, которые могут использовать только авторизованные программы, имеющие соответствующее значение ключа. Эти управляющие блоки создаются системными компонентами для нужд пользовательских приложений.

LSQA, SWA и подпулы фактически разделяют одну область виртуальной памяти, которая примыкает к границе области CSA, а ELSQA, ESWA - к границе 2 GB. Эти области могут увеличиваться за счет незанятых страниц региона пользователя. Следует отметить, что подпулы могут выделяться и в других областях виртуальной памяти. Они служат для группирования логически связанных между собой блоков виртуальной памяти, например по значению ключа защиты, по возможности откачки или свопинга и т.п.

Системный регион System Region резервирует 16 KB виртуальной памяти для хранения служебной информации при выполнении некоторых системных функций.

Рассмотрим далее, какова структура 64-разрядного виртуального адресного пространства, впервые реализованного в z/OS, начиная с версии V1R2. В 64-разрядных пространствах исполняемый программный код по-прежнему может размещаться только в границах младших 2 GB, однако данные, к которым эти программы обращаются, могут быть загружены в виртуальную память свыше 2 GB. В настоящий момент при запуске приложения первоначально создается адресное пространство размером 2 GB, однако по запросу программы оно может быть увеличено (для этого предусмотрена специальная макрокоманда IARV64).

Рис. 5.10. Структура 64-разрядного виртуального адресного пространства

На рис. 5.10 представлена структура 64-разрядного виртуального адресного пространства, которая включает следующие области:

от 0 до 2 GB - сохраняет ранее рассмотренную структуру (см. рис. 5.9) и служит для размещения программного кода и данных для всех типов приложений;от 2 GB до 4 GB - не используемая по архитектурным соображениям область, получившая название Bar1);от 4 GB до 2 TB - нижний регион пользователя (low user region). Используется первым для предоставления памяти свыше границы 2 GB под данные;от 2 TB до 512 TB - разделяемая область (shared area) для совместного использования различными адресными пространствами. В настоящее время не поддерживается;от 512 TB до 16 EB - верхний регион пользователя (high user region). Используется при нехватке памяти в нижнем регионе.

При освоении новых объемов памяти полезно напомнить используемые единицы измерения: 1 терабайт (TB) равен 240 байт или 1024 GB, 1 петабайт (PB) равен 250 байт или 1024 TB, 1 экзабайт (EB) равен 260

байт или 1024 PB.

Для управления объемом выделяемой виртуальной памяти свыше 2 GB в рамках языка управления заданиями для операторов JOB и EXEC реализован новый параметр MEMLIMIT.

Как отмечалось ранее, при переходе к 64-разрядной виртуальной памяти z/OS механизм динамического преобразования адресов DAT модернизируется путем расширения иерархической модели сегментации за счет образования наряду с сегментами более крупных разделов виртуальной памяти.

Эти разделы получили название первый (RF), второй (RS) и третий (RT) регионы ( region first, region second, region third). Самый маленький по размеру третий регион объединяет 2048 мегабайтных сегментов и, таким образом, имеет объем 2 GB. Второй регион объединяет 2048 третьих регионов и имеет объем 4 TB. И наконец, регионы первого типа объединяют 2048 вторых регионов и занимают объем 8 PB каждый. Всего в 64-разрядном виртуальном адресном пространстве может быть создано 2048 первых регионов.

Для управления виртуальной памятью в каждом из дополнительных регионов z/OS формирует три типа таблиц: RTT, RST и RFT. Таблицы третьего региона (RTT) содержат 2048 указателей на размещение "своих" таблиц сегментов (SGT), таблицы второго региона (RST) - указатели на таблицы третьего региона, таблица первого региона (одна на 64-разрядное виртуальное адресное пространство) - указатели на таблицы второго региона. Очевидно, что пятиступенчатый механизм преобразования адресов требует значительных накладных расходов (памяти и времени). В связи с этим разработчики предусмотрели гибкую схему создания и использования таблиц регионов, реализуемую менеджером физической памяти RSM. Если приложение не требует больше 2 GB памяти, то таблицы регионов не используются вообще, и применяется "старая" 31-разрядная процедура DAT, в которой используются только таблица сегментов и таблицы страниц. Когда приложение запрашивает виртуальную память свыше 2 GB ("за барьером") но не более 4 TB, создается таблица третьего региона (RTT) и соответствующее количество таблиц сегментов. Теперь первой в процедуре DAT будет обрабатываться RTT. Менеджер RSM будет создавать все новые уровни таблиц регионов по мере увеличения объема виртуальной памяти, запрашиваемой приложениями. Для управления доступом к памяти на основе механизма DAT в z/OS используется специальная структура, получившая название управляющий элемент адресного пространства ASCE (Address Space Control Element), размещаемый в аппаратных регистрах.ASCE определяет, в частности, какой уровень таблиц региона является старшим для данного адресного пространства.

Управление памятью

Управление основной памятью в z/OS базируется на концепции виртуальной памяти, основные принципы которой были изложены при рассмотрении эволюции системы в п. 5.1.1. Важно подчеркнуть, что в z/OS фактически сохранена архитектура, реализованная в MVS/ESA и развитая в дальнейшем в OS/390. Конечно, расширение разрядности адреса (и, следовательно, объема адресного пространства) не могло не привести к целому ряду нововведений, о которых далее и пойдет речь. Но начнем, однако, с общих понятий и терминов, принятых в MVS, OS/390 и z/OS и необходимых для понимания механизмов управления памятью [4], [5].

В соответствии с концепцией MVS, каждая прикладная программа, а также некоторые системные функции получают в свое распоряжение отдельное виртуальное адресное пространство (virtual address space), размер которого для OS/390 составлял 231 байт, а для z/OS увеличился до 264

байт. Виртуальная память (virtual storage) является воображаемым объектом и фактически представлена в системе как совокупность специальных структур (таблиц), описывающих размещение данных и кода программы в выделенном для нее адресном пространстве. В реальности же выполнение приложений может осуществляться только тогда, когда данные и код загружены в основную память. На рис. 5.8 представлен обобщенный механизм реализации технологии виртуальной памяти.

Рис. 5.8. Элементы системы управления памятью

Некоторое приложение (MYPROG) "размещается" операционной системой в выделенном для него виртуальном адресном пространстве, занимая некоторое количество блоков памяти фиксированной длины, называемых страницами (page). Размер каждой страницы равен 4 KB. Приложение использует виртуальные страничные адреса, и ему доступна любая область собственного адресного пространства.

Чтобы начать выполнение приложения, система загружает его виртуальные страницы в основную память (Central storage), отмечая их местоположение в специальной таблице страниц (page table). Основная память также представлена в виде набора блоков размером 4 KB, называемых фреймами

(frame). При загрузке значения виртуальных адресов сохраняются в неизменном виде. Понятно, что при обращении к памяти требуются реальные физические адреса. Для преобразования виртуальных адресов в физические используется специальный аппаратный механизм динамического преобразования адресов DAT (Dynamic Address Translation), который учитывает реальное размещение виртуальных страниц в основной памяти в момент выполнения адресных команд. Механизм DAT подробно описан в п. 2.1.3. Напомним, что для повышения эффективности управления в системе поддерживается иерархическая модель сегментации виртуальной памяти, в соответствии с которой страницы объединяются в сегменты размером 1 MB (256 страниц на сегмент), а те в свою очередь - в более крупные разделы виртуальной памяти, называемые регионами.

При нехватке основной памяти некоторые страницы могут быть временно перемещены в специальные страничные наборы данных (page data set) во внешнюю вспомогательную память (Auxiliary storage) на магнитных дисках. Блок памяти в страничных наборах получил название слот (slot) и также имеет размер 4 KB. Вытесненные во вспомогательную память страницы находятся там до тех пор, пока не возникнет необходимость в их использовании при выполнении приложения. В этом случае генерируется программное прерывание по отсутствию страницы (page fault) и, при наличии свободных фреймов, запускается процедура "подкачки" страницы из вспомогательной памяти. При занятии страницей свободного фрейма в таблицу страниц вносится его указатель и затем формируется физический адрес.

Конечно, возможна ситуация, когда в основной памяти для загрузки отсутствующей страницы не осталось ни одного свободного фрейма. В этом случае запускается процедура изъятия страниц (page stealing), в результате которой одна или несколько виртуальных страниц "откачиваются" из основной памяти во вспомогательную, чтобы освободить место. Выбор изымаемых страниц основан на классическом методе LRU, использующем формируемые аппаратно биты ключа защиты памяти: бит обращения R и бит изменения С (см.

п. 2.1.3).

Перемещение страниц приложения из основной памяти во вспомогательную и обратно называют страничным обменом (paging), который может происходить многократно в течение всего времени выполнения. При этом следует обратить внимание, что для работы программ вовсе не требуется одновременное присутствие в основной памяти всех ее страниц, равно как и размещение этих страниц в соседних фреймах. Некоторые страницы, содержащие важную системную информацию, могут не участвовать в страничном обмене. Они имеют статус неперемещаемых (fixed) и постоянно находятся в основной памяти. Остальные же страницы считаются перемещаемыми (pagable).

Наряду со страничным обменом в z/OS поддерживается еще одна процедура, управляющая перемещением страниц, - свопинг (swapping). В некоторые критические моменты работы системы (например, при нехватке ресурсов или когда приложение долгое время не проявляет активности) операционная система по инициативе менеджера управления рабочей нагрузкой WLM может принять решение о выгрузке (swap out) всех страниц адресного пространства приложения из основной памяти во вспомогательную. Для этой цели могут создаваться специальные наборы данных свопинга (swap data set). Вытесненным таким образом приложениям не предоставляется процессорное время до тех пор, пока не будет выполнена операция swap in, возвращающая страницы приложения в основную память.

Необходимо отметить, что в операционных системах MVS/ESA и OS/390 для повышения эффективности страничного обмена применялась так называемая расширенная память (Expanded storage), которая, являясь фактическим продолжением основной памяти, использовалась для хранения вытесненных оттуда страниц. Это позволило существенно уменьшить время страничного обмена по сравнению с использованием для той же цели дисковой памяти. Благодаря применяемой для расширенной памяти блочной (а не побайтной) адресации (размер блока - 4 KB), объем расширенной памяти мог достигать 8 GB, в то время как основная память была ограничена размером 2 GB.

В z/OS необходимость в поддержке расширенной памяти отпала, поскольку появилась возможность просто увеличить объем основной памяти (в z900 до 64 GB)!

Таким образом, можно увидеть, что в z/OS виртуальные страницы приложения в процессе выполнения могут быть физически размещены частично в основной, а частично во вспомогательной памяти. Для учета текущего местонахождения и хранения атрибутов виртуальных страниц операционная система создает специальные таблицы, называемые таблицами страниц, сегментов и регионов. В любой момент при необходимости некоторые виртуальные страницы могут сменить "место жительства" на основе страничного обмена или свопинга.

Для управления памятью в базовой управляющей программе z/OS представлены три менеджера памяти (VSM, RSM, ASM), каждый из которых отвечает за свой участок работы (рис. 5.8).

Менеджер виртуальной памяти VSM (Virtual Storage Manager) осуществляет постраничное размещение данных и кода приложений в виртуальном адресном пространстве по запросу, определяет структуру адресных пространств, предоставляет необходимую информацию об использовании виртуальной памяти менеджеру управления нагрузкой WLM. Для этих целей VSM, как и другие менеджеры памяти, предоставляет программисту набор специальных макросредств. Для каждого виртуального адресного пространства VSM строит управляющий блок, получивший название блок управления адресным пространством ASCB (Address Space Control Block). Этот блок содержит информацию и указатели, используемые при управлении адресным пространством. Для идентификации каждое создаваемое адресное пространство получает уникальный номер (идентификатор) ASID (Address Space IDentificator).

Менеджер физической памяти RSM (Real Storage Manager) производит размещение виртуальных страниц в основной памяти, создает и корректирует таблицы страниц, сегментов и регионов, управляет страничным обменом и свопингом. В OS/390 RSM также брал на себя функции управления расширенной памятью.